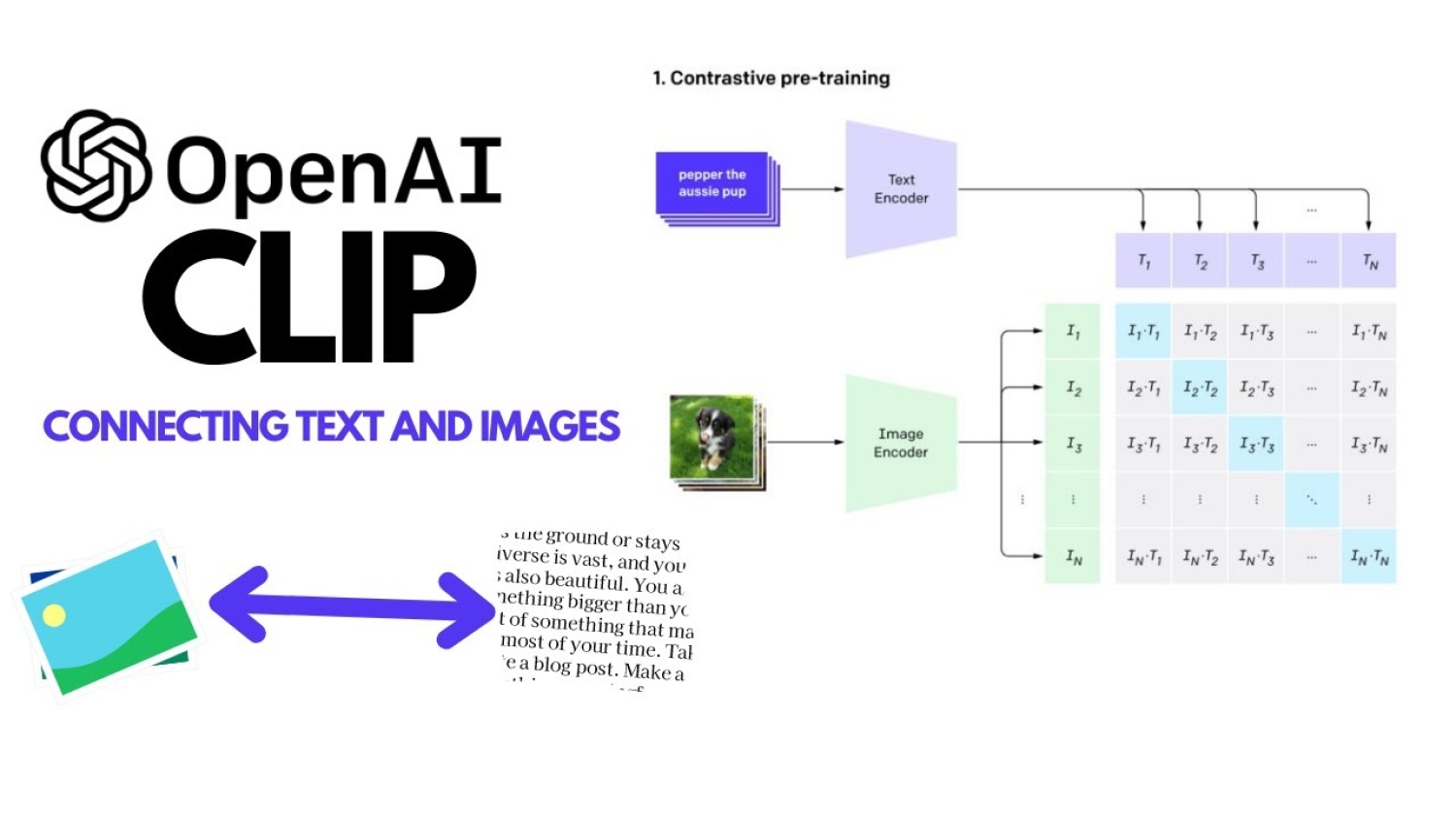

MetaCLIP 2: новая эпоха мультиязычного понимания изображений

Знаете, иногда кажется, что искусственный интеллект понимает лишь одну сторону мира — английскую. Но вот MetaCLIP 2 ломает эту привычку. Он создан с нуля, чтобы учиться на изображениях и текстах со всего света — без переводов, без фильтров, без трудностей английского преобладания. Здесь весь мир представлен в данных, и, честно говоря, это прорыв.

MetaCLIP 2 — это не просто обновлённый CLIP. Он — первая «рецептурная» модель, обученная на миллиардных объёмах данных, на текстах и изображениях на сотнях языков, прямо как они есть. И что особенно интересно: благодаря особому метаданному подходу, тщательной фильтрации и масштабированию обучения, его производительность на английском не страдает, а даже растёт — достигая 81,3 % точности на ImageNet, это на 0,8 % больше, чем у англоязычной модели. Небольшой рост, а эффект — большой.

Но давайте представим: доступ к таким данным — это мостик к культурному разнообразию. MetaCLIP 2 понимает тексты, как их пишут изначально, без переиначивания — и это значит, что модели учатся видеть мир сквозь чужую призму. Он задаёт новый стандарт, позволяя изображениям и словам из самых разных уголков планеты встретиться лицом к лицу в единой модели.

В плюсах: система открыта, код и модели доступны для всех. И да, это не просто ещё один эксперимент — это приглашение к тому, чтобы все языки и культуры стали частью технологического прогресса. Не кажется ли вам, что наконец-то мы можем взглянуть на искусственный интеллект глазами всего мира?