Beijing Academy of Artificial Intelligence (BAAI) анонсировала запуск OmniGen2 — новой открытой мультимодальной генеративной модели, объединяющей текстовую и визуальную генерацию, а также редактирование изображений в единой архитектуре.

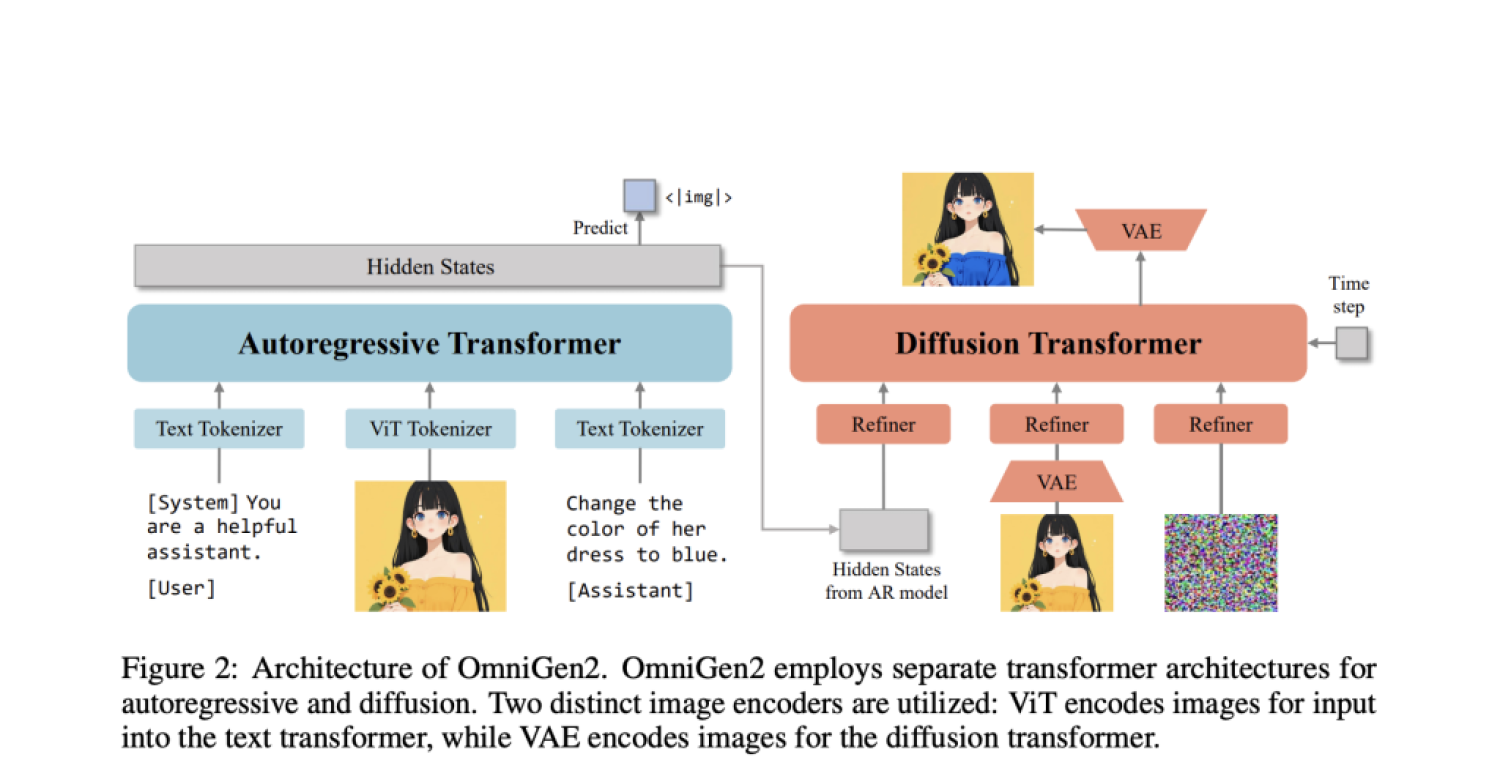

OmniGen2 стала развитием предыдущей версии OmniGen и отличается тем, что впервые реализует раздельное моделирование текста и изображений: для текста используется автогрессивный трансформер, а для изображений — диффузионный трансформер. Новая стратегия позиционирования Omni-RoPE обеспечивает гибкую работу с последовательностями, пространственными координатами и различиями между модальностями, что позволяет достигать высокой точности при генерации и редактировании изображений.

Важной особенностью OmniGen2 стал механизм рефлексии: модель получает обратную связь на каждом этапе обучения, анализирует свои результаты, выявляет несоответствия и самостоятельно корректирует ошибки. Такой подход значительно повышает точность следования инструкциям и визуальную согласованность, особенно при сложных задачах, например, изменении цвета, количества объектов или их расположения.

Для оценки качества контекстной генерации разработан специальный бенчмарк OmniContext, включающий задачи с одним или несколькими объектами и целыми сценами. OmniGen2 показала лучшие среди открытых моделей результаты, обойдя такие решения, как BAGEL и UniWorld-V1. Оценка проводилась по трём метрикам: соответствие запросу, согласованность объекта и итоговый балл, проверяемый с помощью reasoning-модели на базе GPT-4.1.

Модель обучалась на 140 миллионах текстово-визуальных пар и 10 миллионах собственных изображений, а также на специально подготовленных датасетах для контекстной генерации и редактирования. Для этого использовалась видеоплатформа, автоматически извлекающая последовательные кадры и генерирующая инструкции с помощью Qwen2.5-VL.

OmniGen2 продемонстрировала высокие результаты по всем направлениям: в генерации изображений по тексту, редактировании, работе с контекстом и механизмах самокоррекции. Эксперты отмечают, что открытость кода и данных создаёт прочную базу для дальнейших исследований в области управляемой и согласованной генерации изображений и текста. В будущем разработчики планируют внедрять методы обучения с подкреплением для улучшения механизма рефлексии и расширять мультиязычные возможности модели.