Исследователи из Массачусетского технологического института разработали систему Themis, которая позволяет моделям искусственного интеллекта распознавать области, в которых они могут ошибаться. Это важный шаг к повышению надёжности и прозрачности алгоритмов ИИ в различных сферах применения — от медицины до автономных транспортных систем.

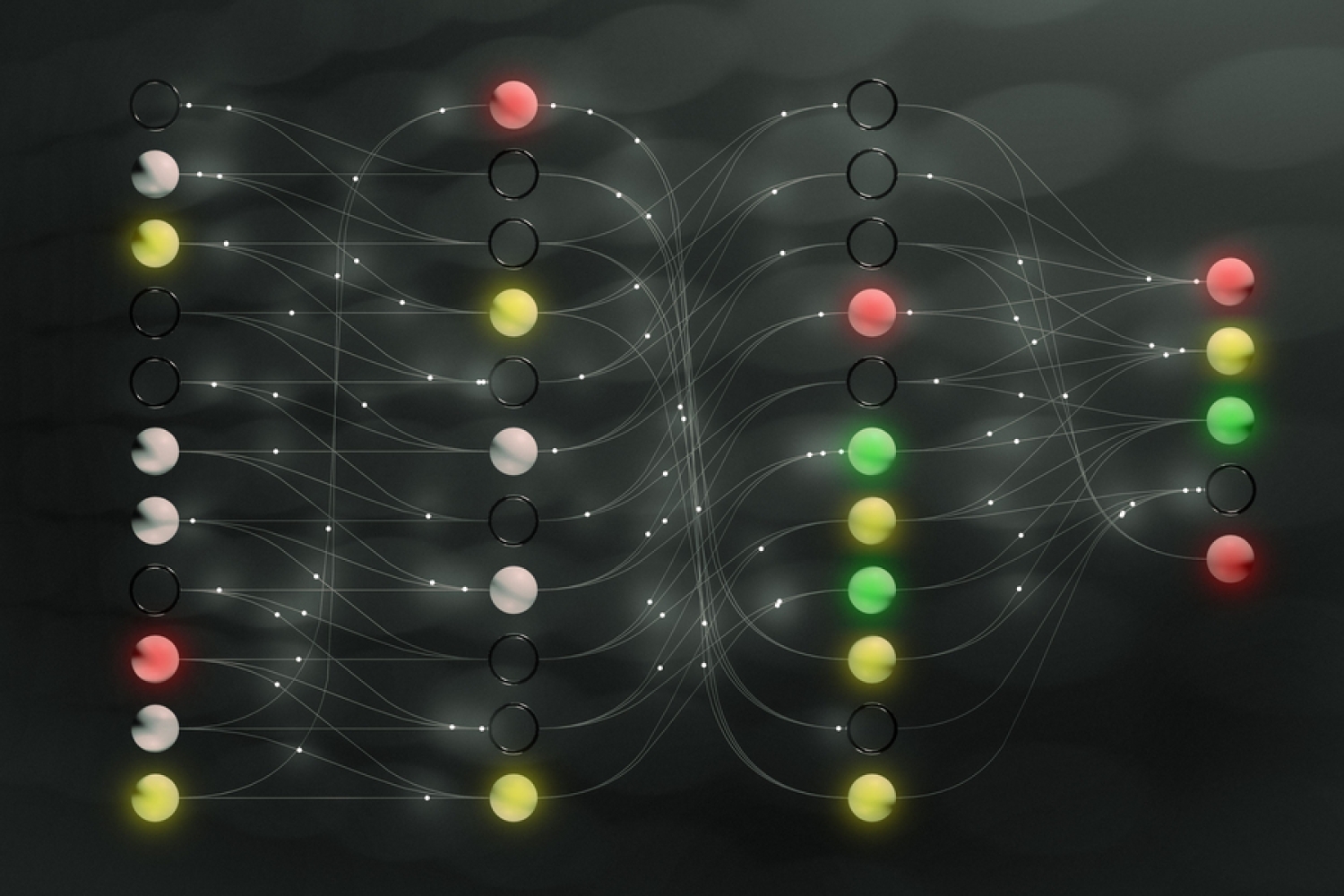

Одной из главных проблем современных моделей машинного обучения является то, что они часто не способны объективно оценить уровень своей уверенности в выводах. Это может привести к неправильным решениям, особенно в критически важных областях. Themis обучает ИИ выявлять, когда модель «не знает» ответа или не уверена в предсказании, что позволяет либо запросить дополнительную информацию, либо передать решение человеку.

В отличие от стандартных подходов, Themis не требует изменения архитектуры модели или значительного увеличения вычислительных ресурсов. Она может быть встроена в уже существующие модели, помогая им стать более адаптивными и безопасными. Themis демонстрирует особенно высокую эффективность в задачах классификации и анализа, где традиционные методы дают сбои.

По словам разработчиков, внедрение Themis может значительно повысить доверие к ИИ-системам и ускорить их интеграцию в социально значимые сферы. В условиях стремительного роста применения ИИ важно не только точность, но и способность признавать свои ограничения.