Мир моды оценивался в $1,84 трлн в 2025 году, и вместе с этим масштабом приходит и риск появления нежелательного контента. Представьте: дизайнеры загружают свежие эскизы и видео, а где-то на заднем фоне скрываются оскорбительные или токсичные образы. Кто не хочет защитить свою репутацию и доверие клиентов?

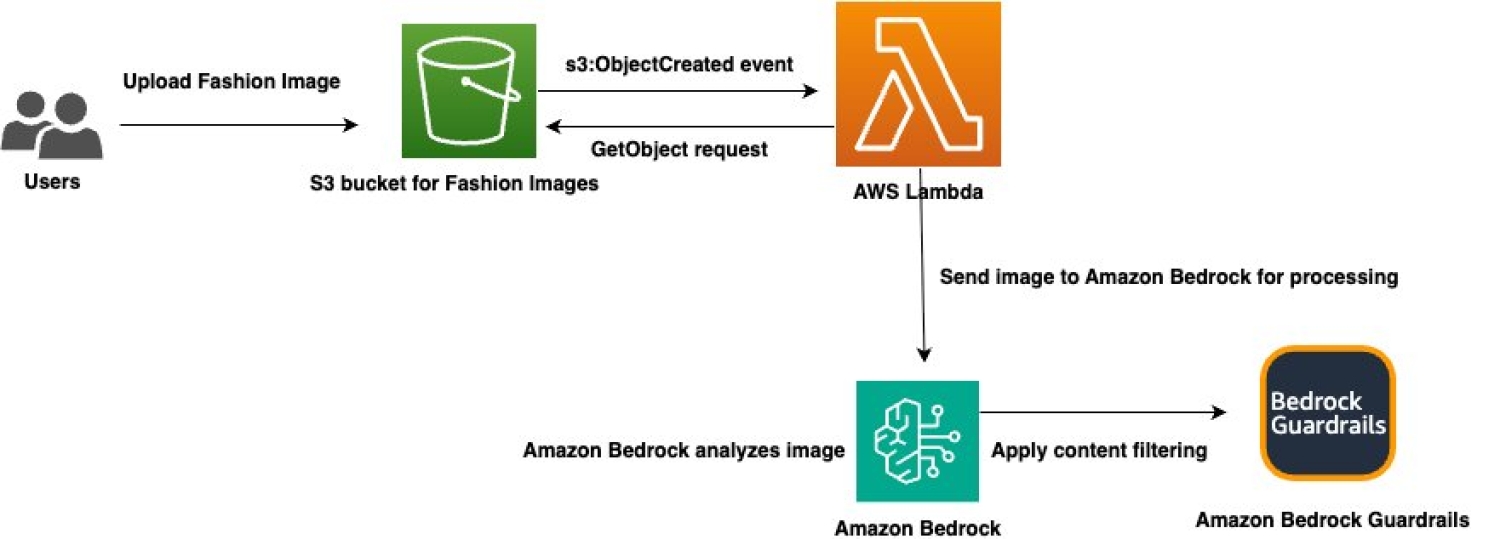

Как всё работает

Вместо ручных проверок можно выстроить полностью автоматический конвейер модерации. Суть проста: каждая новая картинка попадает в хранилище, где запускается функция, а дальше Amazon Bedrock Guardrails прогоняет её через «мультимодальный детектор токсичности». Результат? Либо «проход» и публикация, либо «блок» с причиной — и вы успеете вовремя отреагировать.

Шаг 1: Создаём защитный барьер

В консоли Amazon Bedrock переходите в раздел Guardrails и создаёте новый «мультимодальный» фильтр. Задаёте категории — Hate, Insults, Sexual, Violence — для изображений и текста. Две минуты настроек, и ваш барьер готов.

Шаг 2: Хранилище для изображений

Amazon S3 служит точкой старта. Создаёте бакет, указываете регион и стандарты безопасности. Именно сюда дизайнеры и другие процессы будут загружать контент для проверки.

Шаг 3: Серверная логика на Python

Lambda-функция подхватывает событие «новый объект в S3», читает картинку и проверяет формат (JPEG или PNG) и размер (до 4 МБ). Потом она вызывает API ApplyGuardrail, передаёт данные и получает ответ: блокировать или пускать дальше. Логи в CloudWatch покажут, какая категория сработала — и вы сразу поймёте, где подправить политику.

Шаг 4: Автоматическое триггерирование

Привязываете S3-триггер к вашей функции — и дело сделано. При любом новом загрузке Lambda сама запустится, прогонит картинку через фильтры и запишет результат в логи.

Результат и выводы

Такой конвейер позволяет брендам оставаться на гребне волны: быстрее запускается контент, а риски скандалов сводятся к минимуму. Честно говоря, уже не нужно ломать голову над каждым файлом — система сама отметит опасные эпизоды.