Исследователи Apple опубликовали результаты эксперимента, выявившего критические слабости в логике современных языковых моделей ИИ при решении нестандартных задач. Работа указывает на фундаментальные структурные ограничения даже у крупнейших моделей.

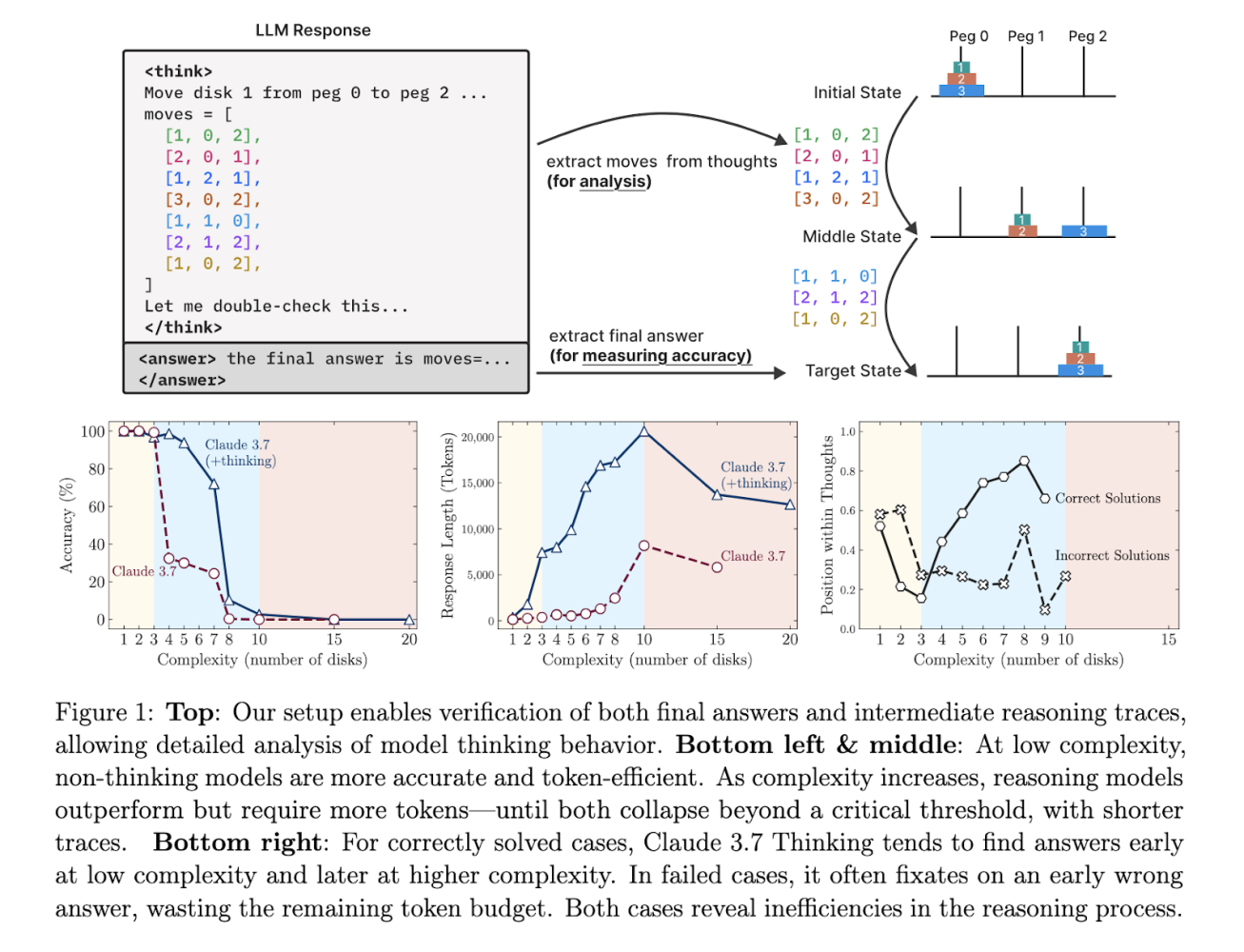

Специалисты предложили новый метод оценки под названием PuzzleBench — набор тестов на основе логических головоломок, которые требуют от моделей не просто генерации текста, а построения цепочки рассуждений. По словам авторов, такой формат позволяет глубже понять, насколько ИИ способен к когнитивной гибкости.

«Большинство моделей, даже обладая большим числом параметров, проваливаются на задачах, требующих базовых логических выводов или работы с переменными. Это указывает на отсутствие у них настоящего понимания структуры задачи», — отметили авторы исследования.

В тестировании приняли участие модели разных масштабов, включая широко используемые коммерческие решения. Несмотря на успехи в генерации связного текста, модели допускали ошибки в решениях, где требовалась многокомпонентная логика или абстрактное мышление.

Авторы подчёркивают, что PuzzleBench может стать новым стандартом оценки для будущих ИИ-систем, ориентированных на решение задач, требующих продвинутого мышления. Это особенно актуально на фоне растущего числа ИИ-приложений в сферах образования, медицины и технической экспертизы.

Эксперты индустрии отмечают, что подобные исследования важны для перехода от поверхностного ИИ к более «мыслящим» системам. Ожидается, что PuzzleBench поспособствует созданию более надёжных моделей, ориентированных на точность и обоснованность выводов.